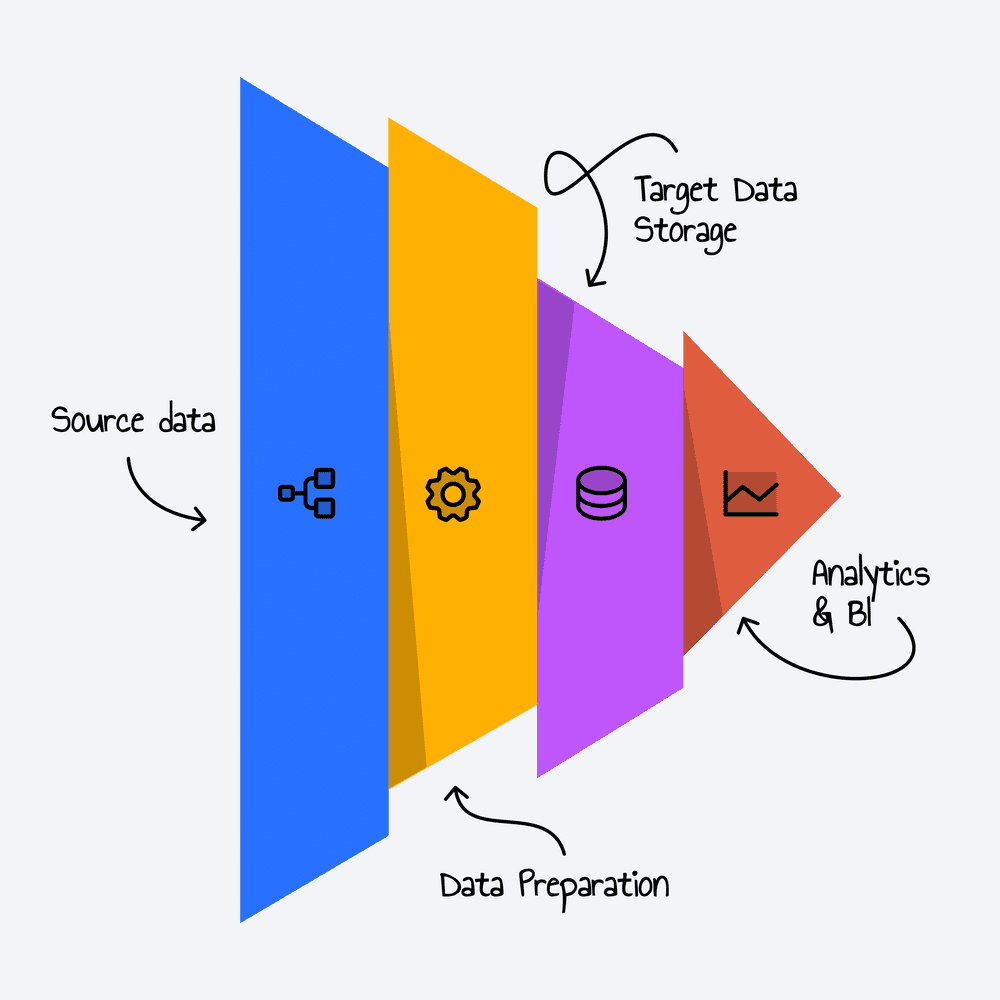

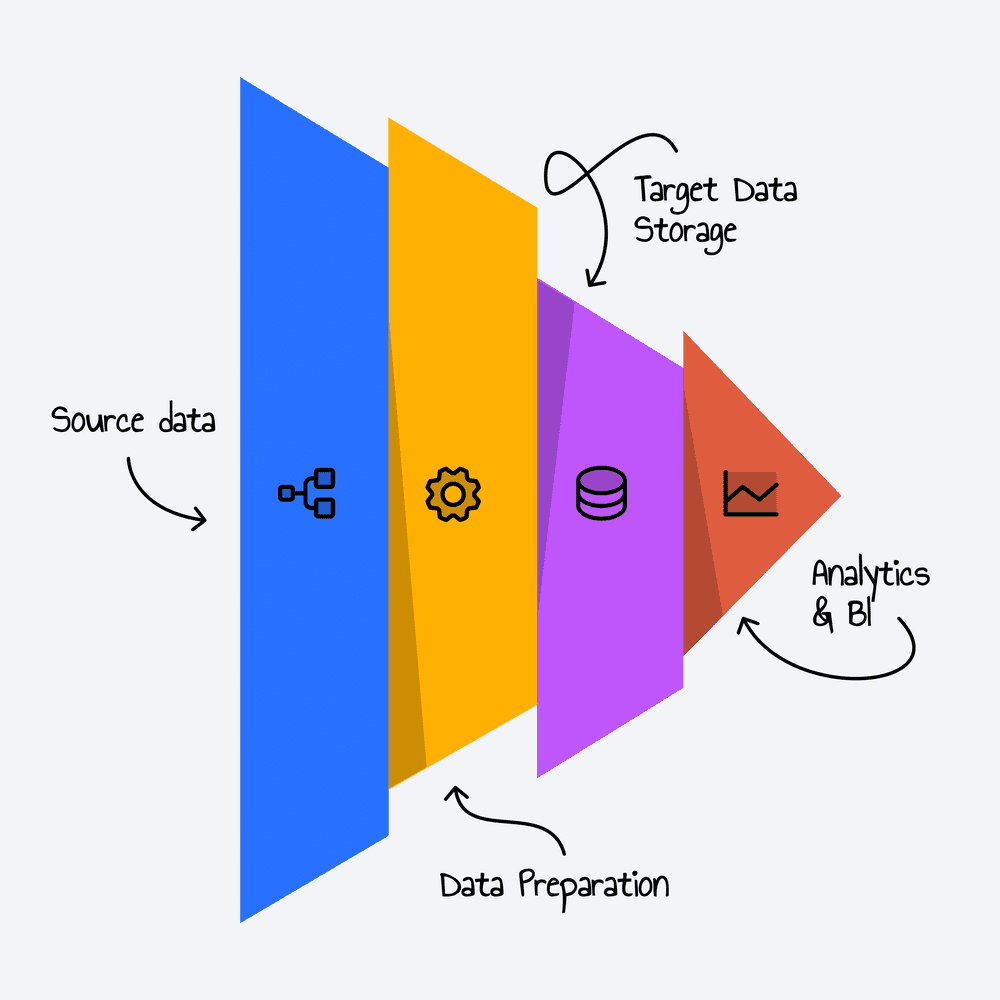

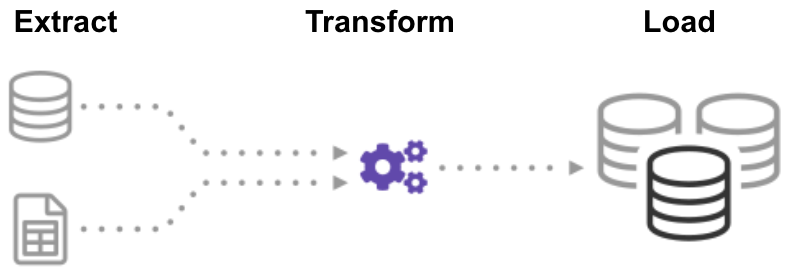

L'ETL est le processus qui consiste à combiner les données provenant de plusieurs sources dans un grand référentiel central appelé entrepôt des données (data warehouse).

La collecte

Nous implémentons des systèmes de récolte de données externes ou internes par différentes méthodes : API, accès FTP, flux XML, scraping, requêtes SQL etc. Ces systèmes sont robustes et des mécanismes d’alerte permettent de savoir si les sources de données évoluent.

Le traitement

Nous mettons en place des pipelines qui automatisent le flux de gros volumes de données depuis les sources d’origine vers les systèmes de stockage. Ces pipelines assurent la transformation, le nettoyage et la normalisation des données pour une utilisation efficace dans l’analyse.

Le chargement

Les données sont chargées dans des systèmes de données scalables, optimisés pour des performances élevées.